Sitemap.xml — что это?

Файл sitemap.xml — это своеобразная карта сайта, которая показывает поисковым роботам, какие страницы веб-ресурса должны попасть в индекс ПС. Sitemap.xml рекомендуется создавать, чтобы:

Требования к файлу от ПС Яндекс:

Требования к файлу от ПС Google:

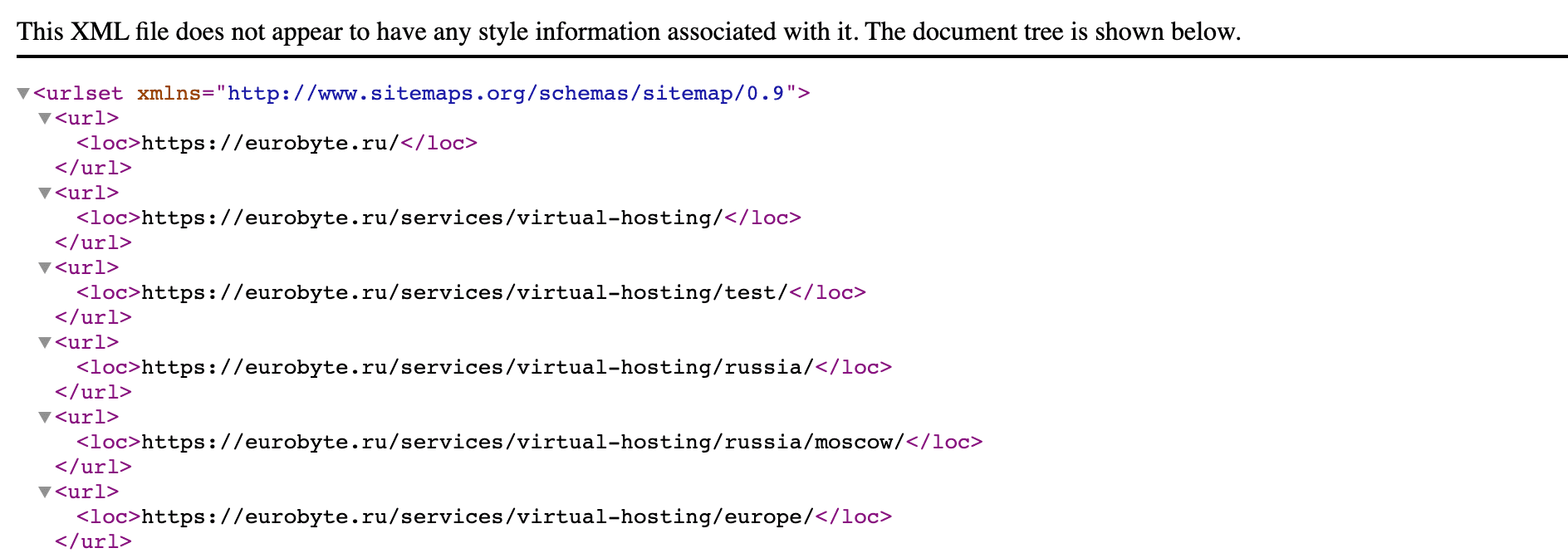

Пример того, как выглядит часть карты сайта нашего проекта.

В ней перечислены все важные страницы нашего сайта, которые должны попасть в поиск.

Запомните, что поисковые системы не гарантируют попадание веб-страницы в индекс даже при наличии на нее ссылки в карте сайта.

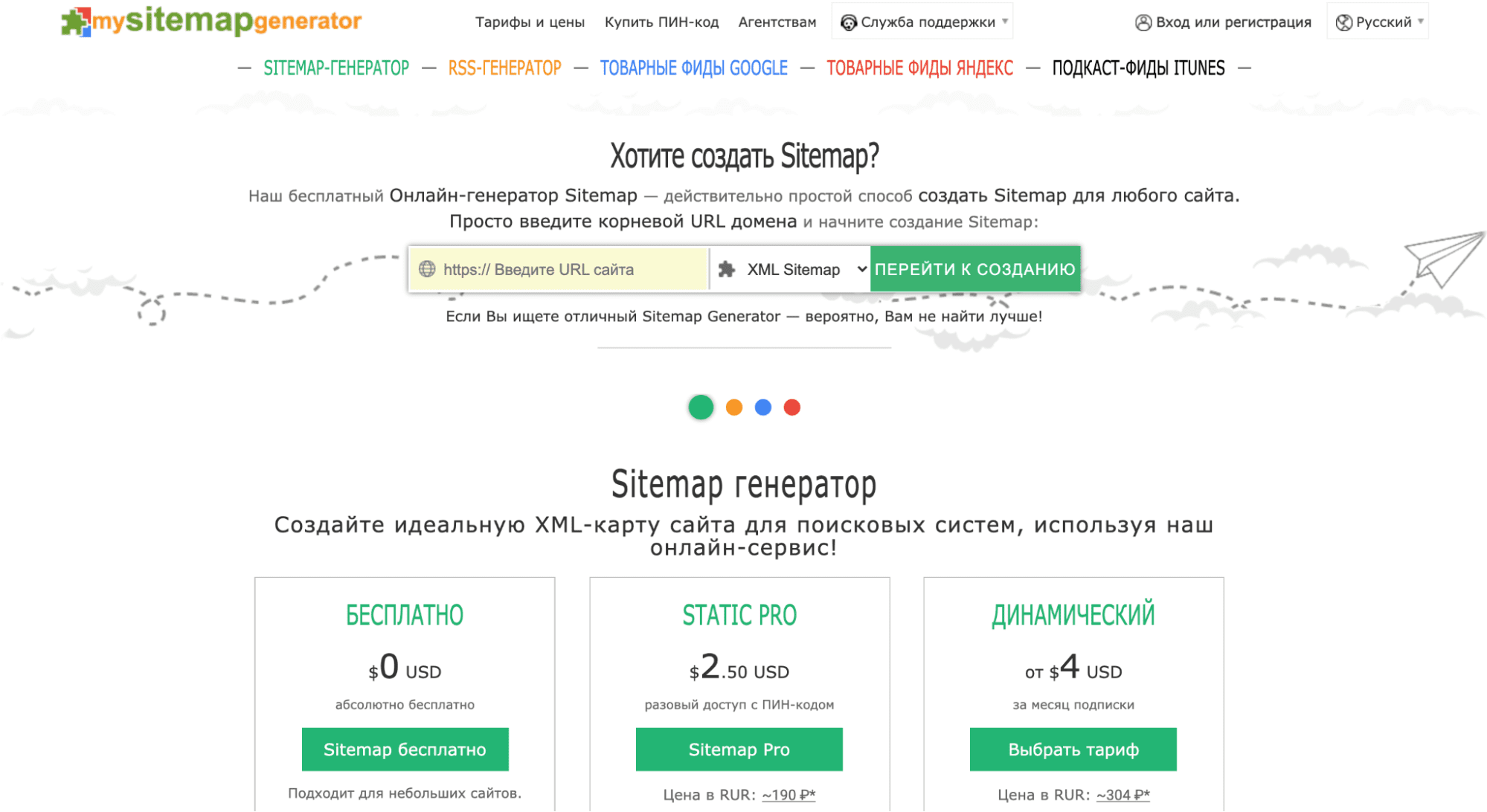

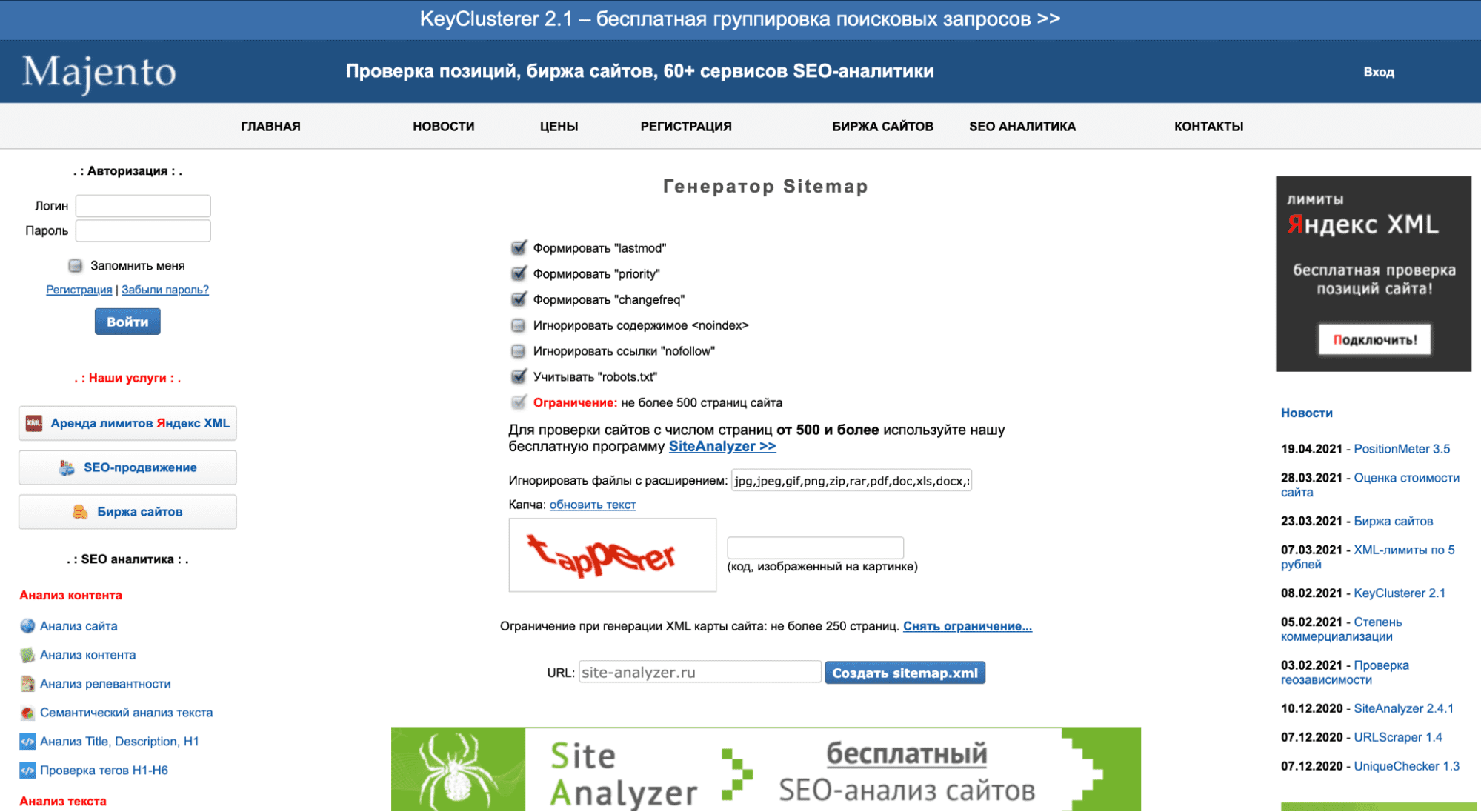

Сайтмап можно создать вручную или сгенерировать файл автоматически. Ниже мы покажем примеры бесплатных генераторов, которые помогут создать карту сайта.

Бесплатная версия инструмента подходит для небольших проектов (до 500 URL). Есть возможность создать карту сайта как в формате XML, так и в HTML. Просто введите URL проекта и нажмите кнопку «Перейти к созданию».

Инструмент позволяет в режиме онлайн сгенерировать карту сайта до 500 страниц. Есть функции: формировать lastmod, priority, changefreq, игнорировать содержимое noindex и ссылки nofollow, учитывать директивы в robots.txt.

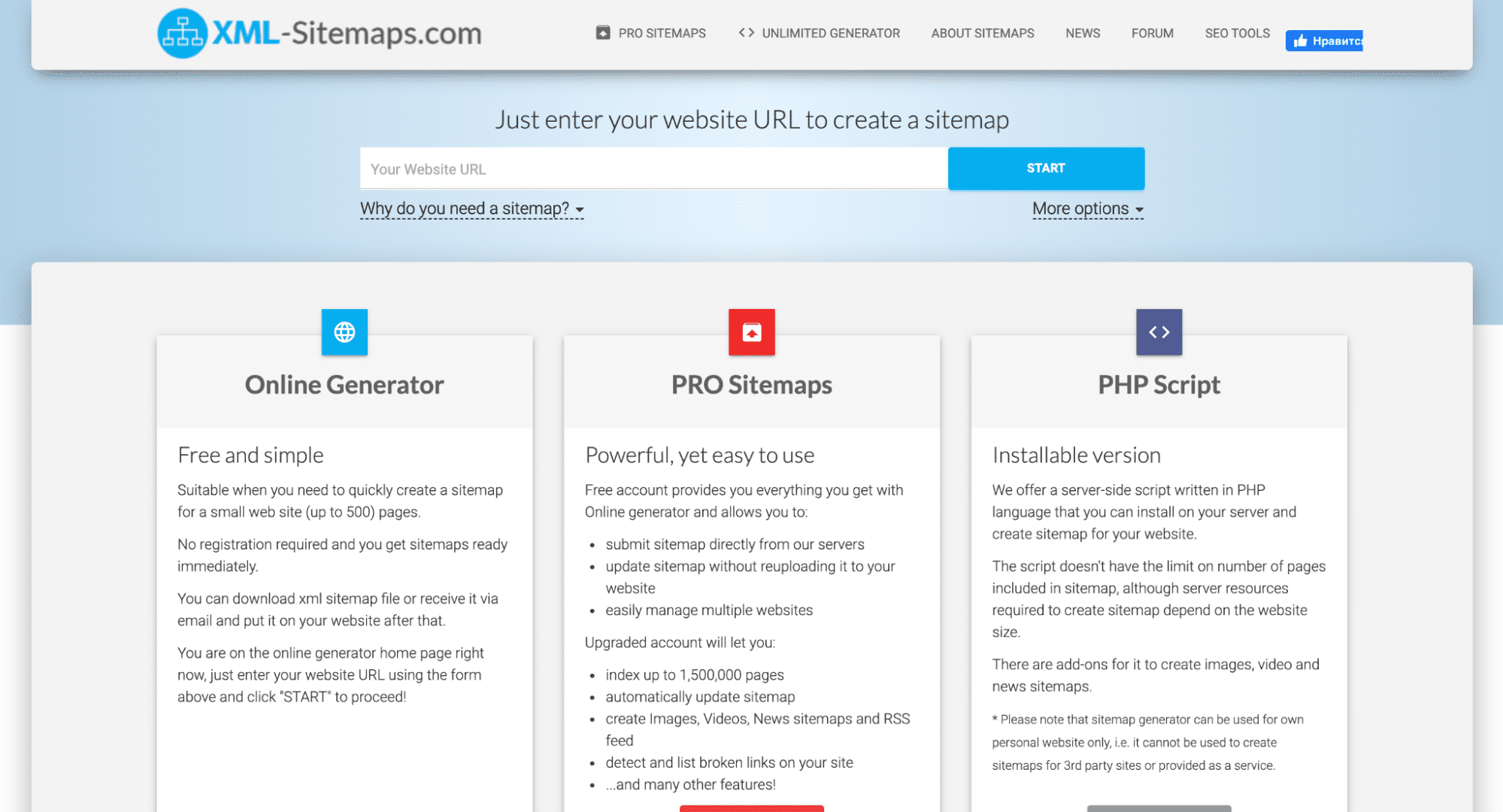

Еще один онлайн-генератор с ограничением по URL в пятьсот штук. Регистрация не требуется, вы сразу же получите готовую карту сайта. Вы сможете скачать файл карты сайта в формате XML или получить его по электронной почте, а потом разместить на своем веб-сайте.

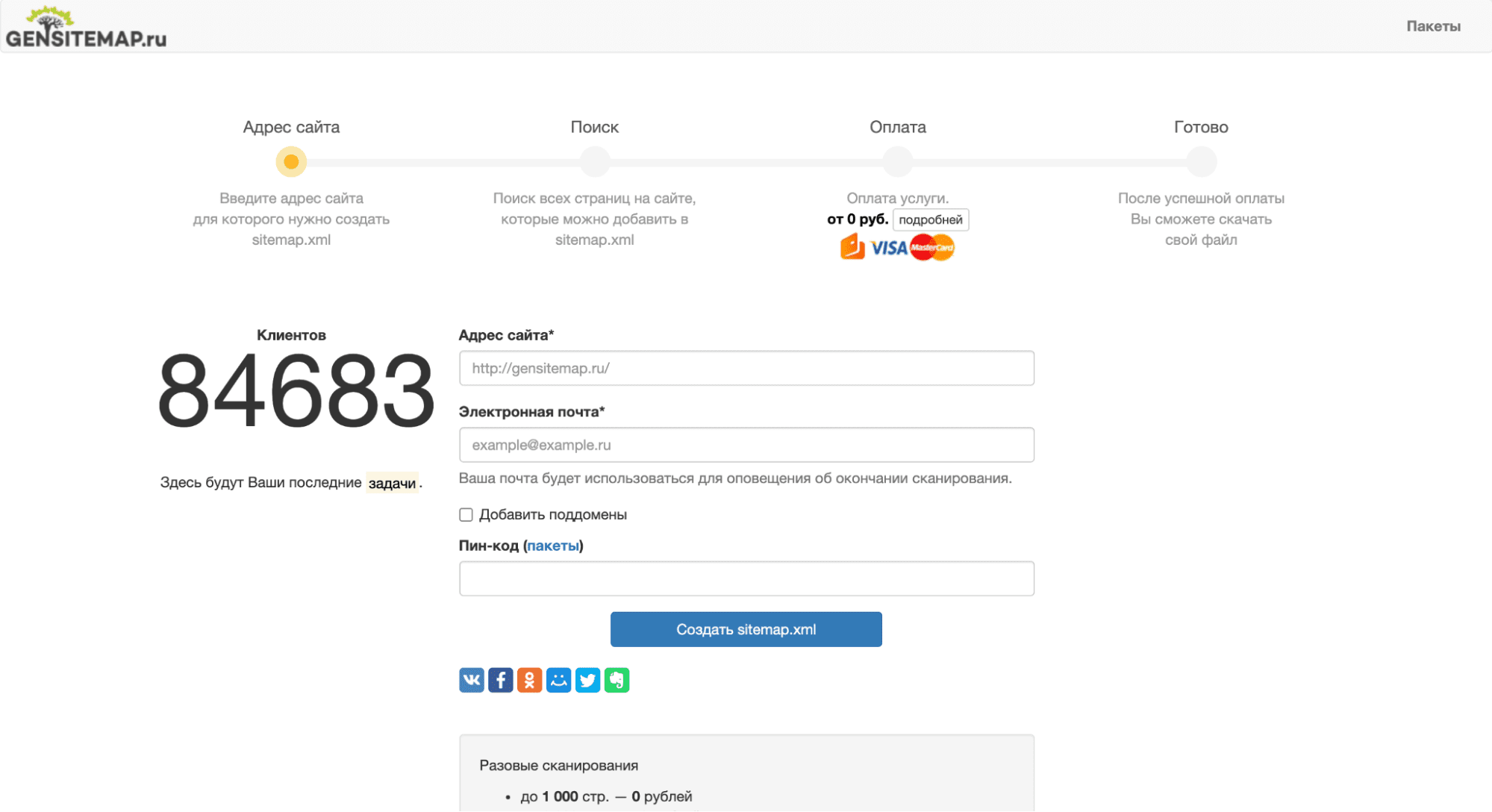

Разовое сканирование сайта до 1000 страниц обойдется вам бесплатно. Просто введите полный адрес сайта и электронную почту (на нее придет оповещение об окончании сканирования).

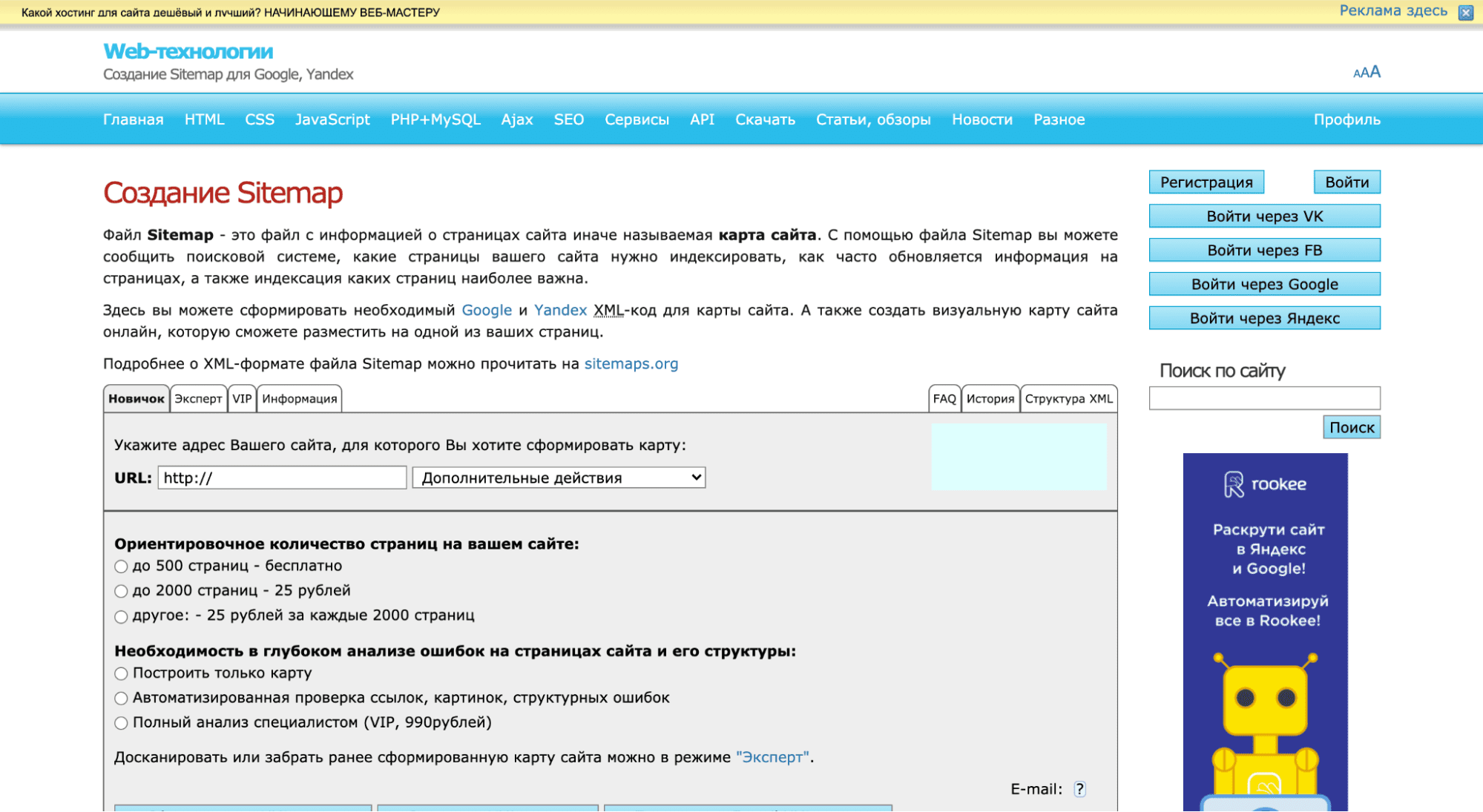

Инструмент от htmlweb позволяет бесплатно сканировать до 500 страниц сайта. Есть дополнительные функции: понижать приоритет по подпапкам, брать last-modified из заголовка или в ссылки вставлять title страницы.

Таким образом, файл sitemap нужен для качественной и быстрой индексации вашего сайта. Поисковые системы, скорее всего, и без него найдут страницы вашего веб-ресурса, но sitemap.xml облегчает и ускоряет этот процесс. Если у вас остались вопросы, задавайте их в комментариях. Мы обязательно ответим. Спасибо, что дочитали!

Автор: ЕвробайтПоделиться

Факторы ранжирования — это совокупность факторов и признаков, по которым поисковые системы понимают, на каком месте должна отображаться страница сайта в поисковой выдаче.

Robots.txt — это специальный текстовый файл, с помощью которого можно управлять индексацией страниц сайта в поисковых системах (ПС), например, Яндекс и Google.

Реферальный маркетинг — это инструмент для продвижения продукта или услуги с помощью реальных людей.

Надёжные VPS серверы с посуточной оплатой в России и Европе.

От 10 ₽ в день!

Арендовать виртуальный сервер